[멋쟁이사자처럼 데이터분석 부트캠프 5기] 웹 크롤링 연습해보기

0. 학습목표

데이터 수집 수업에서 배운 웹 크롤링을 혼자서(강조) 연습해보려고 한다.

강사님께서 알려주신 코드 + gpt로 연습 할 것이다.

혼자서 페이지 2개 긁어와보기 !!

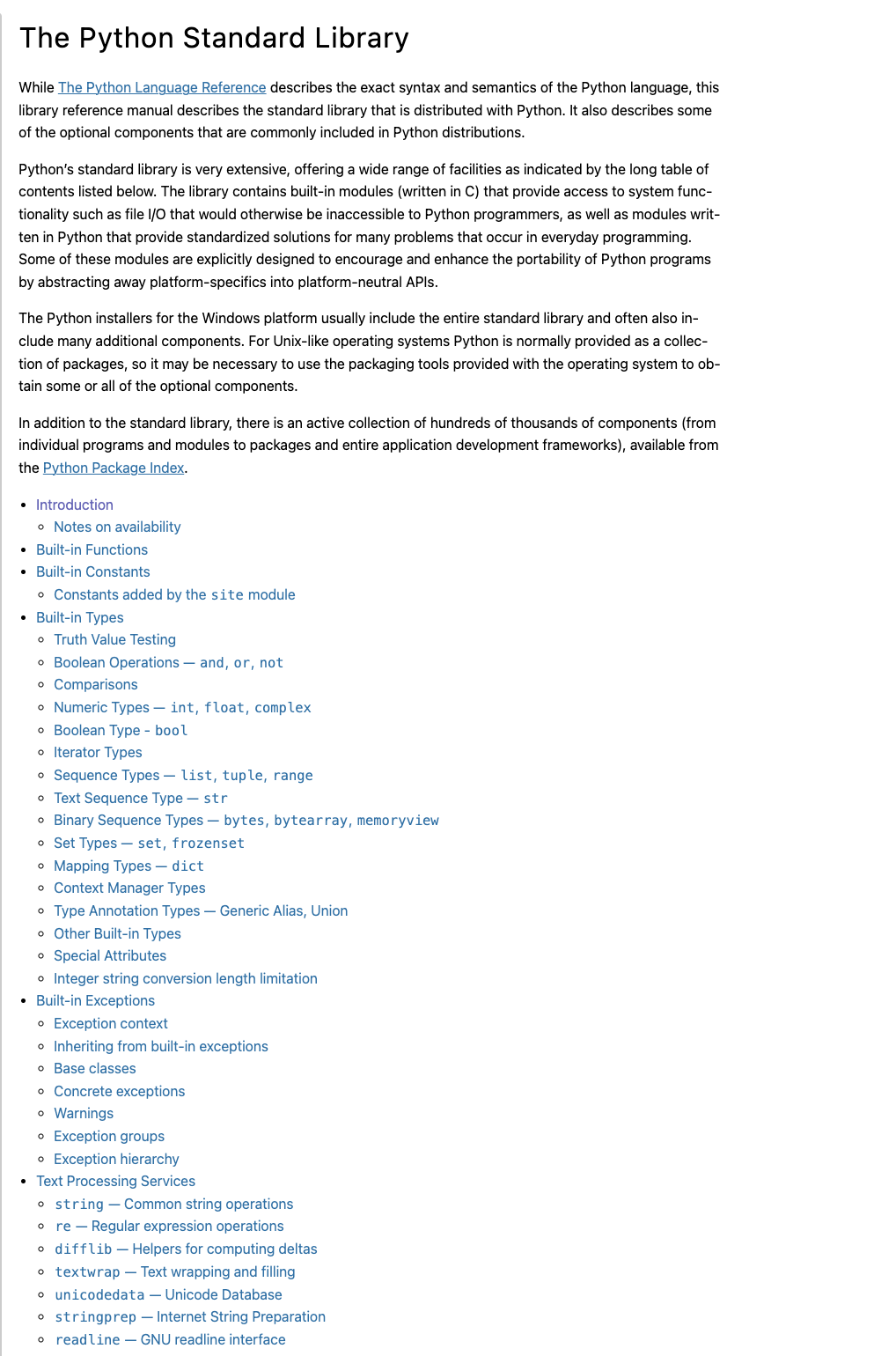

1. 파이썬 홈페이지 library reference 목차 긁어오기

크롤링 할 페이지 :

The Python Standard Library

While The Python Language Reference describes the exact syntax and semantics of the Python language, this library reference manual describes the standard library that is distributed with Python. It...

docs.python.org

파란색 글씨로 적힌 목차와 링크를 크롤링 해와서 csv 파일로 저장할 것이다.

# 라이브러리 불러오기

import bs4

import requests

import pandas as pd

import numpy as np

import os

from IPython.display import clear_output# 소스 요청 함수

def getSource(site):

header_info = {

'User-Agent' : 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/135.0.0.0 Safari/537.36'

}

response = requests.get(site, headers = header_info)

# bs4 객체 생성

soup = bs4.BeautifulSoup(response.text, 'lxml')

return soup

📌 getSource(site) 함수 요약

- 헤더 정보 설정

- 웹 서버에 정상적인 브라우저처럼 보이게 하려고 User-Agent 정보를 설정한다.

- HTTP 요청 보내기

- requests.get()을 사용하여 지정한 site URL에 GET 요청을 보내고, 응답(response)을 받는다.

- BeautifulSoup 객체 생성

- response.text를 lxml 파서로 읽어들여 BeautifulSoup 객체(soup)를 생성한다.

- 파싱 결과 반환

- 생성한 soup 객체를 반환한다.

이제 받은 소스 코드에서 내가 원하는 부분을 추출해와야한다.

난 목차 data만 필요하기 때문에 개발자 코드 (fn+f12)에서 목차 부분을 찾고

copy selector 해온다.

< 접근 순서 >

#the-python-standard-library > div (목차 전체 묶음)

⬇️

#the-python-standard-library > div > ul (목차 텍스트)

⬇️

#the-python-standard-library > div > ul > li:nth-child(1) > a (링크)

# data 수집 & 저장

def getData(soup, file_name) :

# 데이터가 있는 전체를 불러온다

a1 = soup.select_one('#the-python-standard-library > div')

# 수집한 데이터를 담아 저장하는 용도로 사용할 딕셔너리

data_dict = {

'제목' :[],

'링크' :[],

}

li_list = a1.select('ul > li')

for li in li_list:

a_tag = li.select_one('a')

if a_tag :

title = a_tag.text.strip()

link = a_tag.get('href')

data_dict['제목'].append(title)

data_dict['링크'].append(link)

df1 = pd.DataFrame(data_dict)

# display(df1)

# 저장한다.

if os.path.exists(file_name) == False :

df1.to_csv(file_name, encoding = 'utf-8-sig', index = False)

# 만약 파일이 있다면

else :

df1.to_csv(file_name, encoding = 'utf-8-sig', index = False, header = None, mode = 'a')📌 getData(soup, file_name) 함수 요약

- HTML 요소 가져오기

- soup.select_one('#the-python-standard-library > div')를 사용하여 주요 콘텐츠 영역을 선택한다.

- 빈 딕셔너리 생성

- data_dict에 '제목'과 '링크'를 저장할 리스트를 초기화한다.

- 리스트 항목 추출

- 선택한 div 내의 ul > li 요소들을 모두 가져온다.

- 각 항목에서 제목과 링크 추출

- 각 li에서 <a> 태그를 찾아 텍스트(제목)와 href(링크)를 가져와 data_dict에 추가한다.

- DataFrame 생성

- 수집한 딕셔너리를 pandas.DataFrame으로 변환하여 표 형식으로 구성한다.

- CSV 파일 저장

- 파일이 없다면: 새로 저장 (header 포함).

- 파일이 있다면: 기존 파일에 내용 추가 저장 (header 없이 append).

자 이제 만들어둔 코드를 실행시켜 보자.

soup = getSource('https://docs.python.org/3/library/index.html')

getData(soup, 'Pydata.csv')

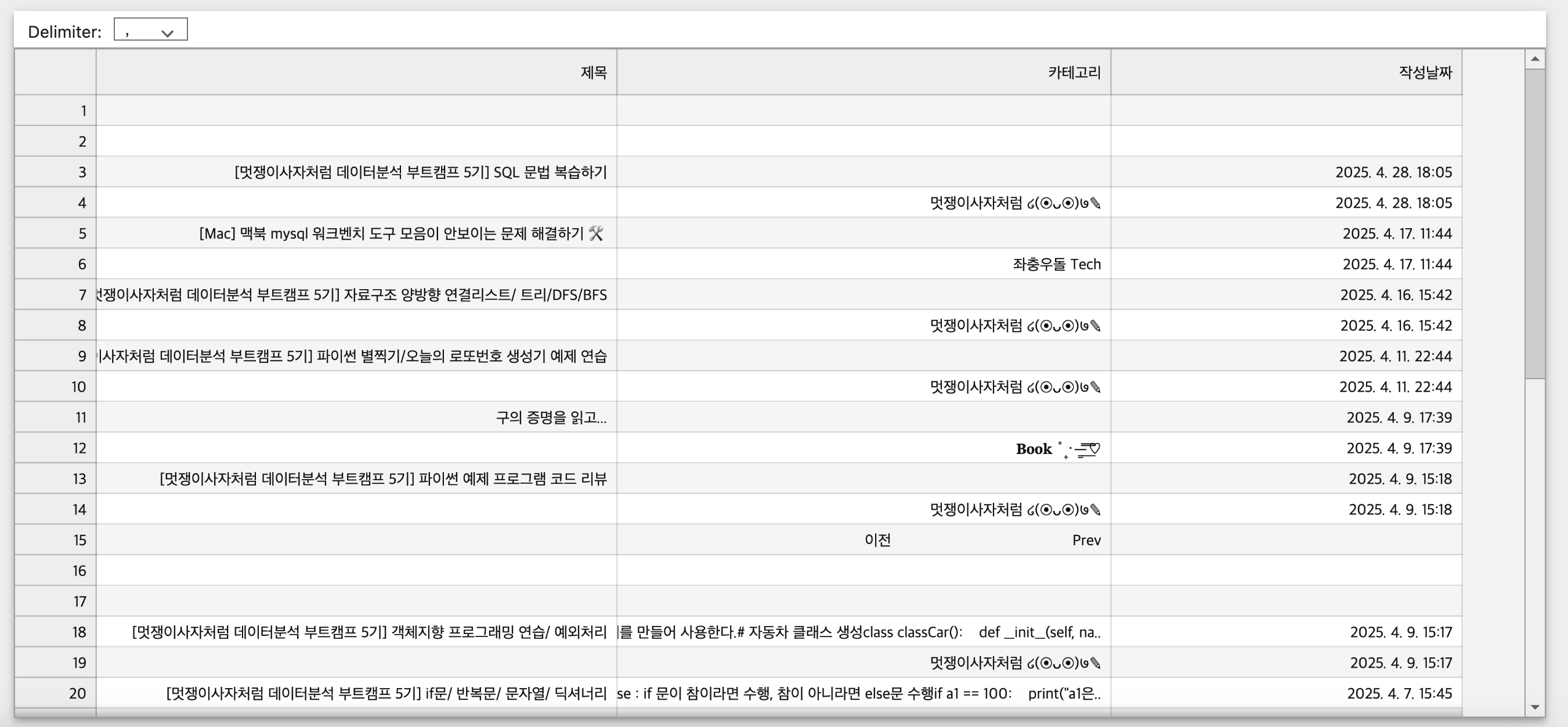

Pydata.csv 파일로 만들어진 것을 확인할 수 있었다 !

목표대로 제목과 링크 제대로 저장되었다. 👍

2. 나의 티스토리 블로그의 글 제목, 글 카테고리, 작성일자 를 크롤링해보자

1) 기본 세팅 (1번 문제와 동일하다)

import bs4

import requests

import pandas as pd

import numpy as np

import os

import time

from IPython.display import clear_output# 소스 요청 함수

def getSource(site):

header_info = {

'User-Agent' : 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/135.0.0.0 Safari/537.36'

}

# 요청한다.

response = requests.get(site, headers=header_info)

# bs4 객체를 생성한다.

## BeautifulSoup은 HTML 또는 XML 문서를 파싱하고 구조화해서 데이터를 쉽게 추출할 수 있도록 도와주는 도구

soup = bs4.BeautifulSoup(response.text, 'lxml')

return soup

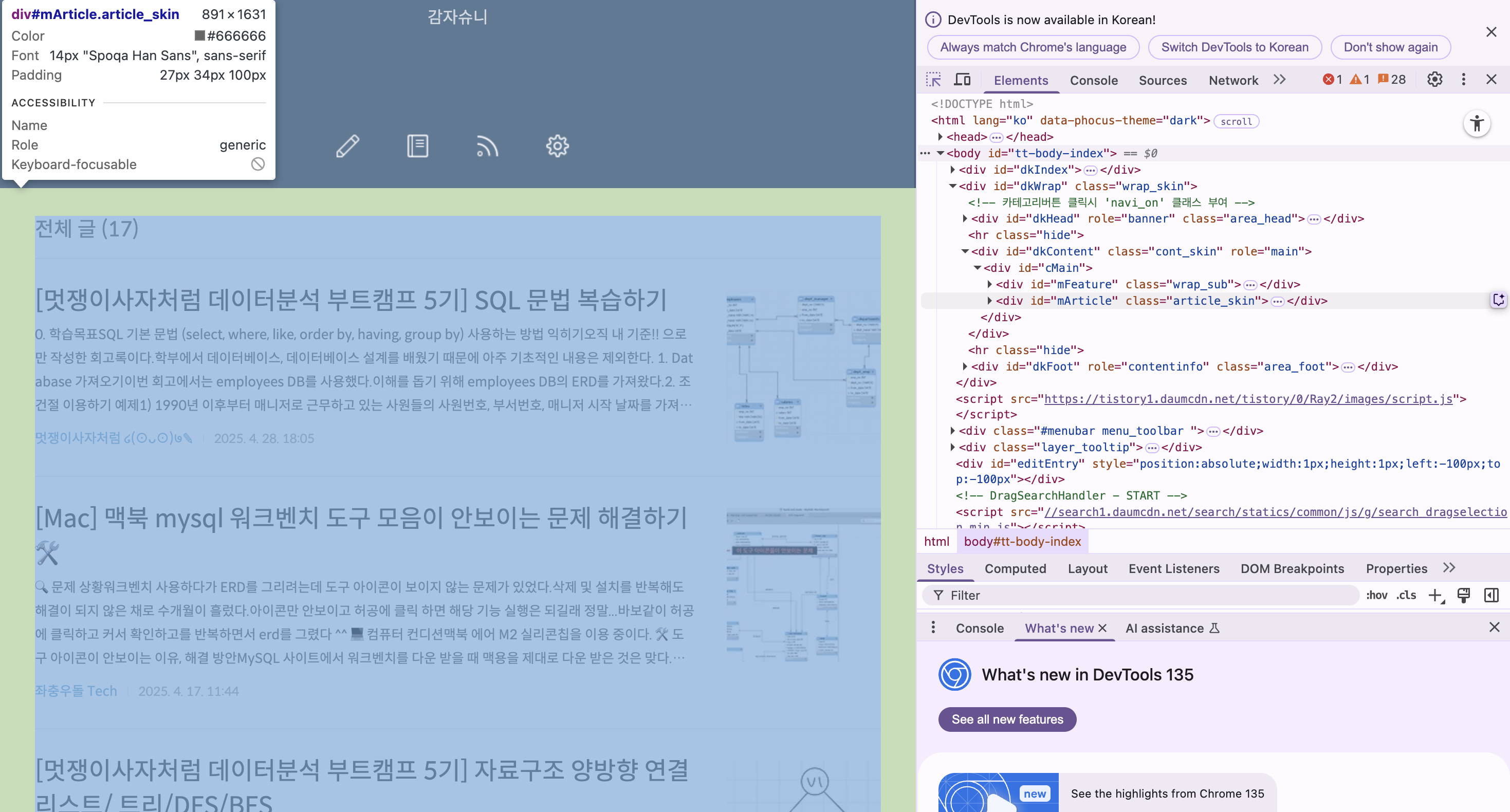

< 접근 순서 >

#mArticle (글이 있는 곳 전체)

⬇️

#mArticle > div (각각의 글들)

⬇️

#mArticle > div > a.link_post > strong (글의 제목)

⬇️

#mArticle > div:nth-child(3) > div > a (카테고리)

⬇️

#mArticle > div:nth-child(3) > div > span.txt_date (작성 날짜)

2) 데이터 수집 함수

# 한 페이지의 데이터를 수집해 저장하는 함수

def getData(soup, file_name):

# 데이터가 있는 전체를 가져온다

a1 = soup.select_one('#mArticle')

# 수집한 데이터를 담을 리스트

data_list = []

# 내부의 태그들 가져오기

a2 = a1.select('div')

for div in a2 :

# 제목 가져오기

# #mArticle > div:nth-child(3) > a.link_post > strong

a3 = div.select_one('a.link_post > strong')

title = a3.text.strip() if a3 else None

# 카테고리 가져오기

# #mArticle > div:nth-child(3) > div > a

a4 = div.select_one('a')

category = a4.text.strip() if a4 else None

# 작성날짜 가져오기

# #mArticle > div:nth-child(3) > div > span.txt_date

a5 = div.select_one('span.txt_date')

date = a5.text.strip() if a5 else None

# 리스트에 데이터들을 담는다

data_list.append({

'제목': title,

'카테고리': category,

'작성날짜': date

})

# 딕셔너리를 가지고데이터 프레임을 생성한다.

df1 = pd.DataFrame(data_list)

#display(df1)

# 파일로 저장한다. (Index는 저장하지 않는다)

if os.path.exists(file_name) == False:

df1.to_csv(file_name, encoding = 'utf-8-sig', index = False)

else:

df1.to_csv(file_name, encoding = 'utf-8-sig', index = False, header = None, mode = 'a')

이번에는 여러 페이지가 있는 사이트 이기 때문에

다음 페이지 주소를 가져오는 함수도 필요하다.

# 다음 페이지 주소를 가져오는 함수

def getNextPage(soup) :

# Next 버튼의 태그를 가져온다.

next_tag = soup.select_one('#mArticle > div.area_paging > span > a.btn_next')

print(next_tag)

if next_tag != None :

# href 속성의 값을 가져온다.

# 다음 페이지의 링크

href = next_tag.get('href')

if href :

return href

else :

return None

else:

return None# 수집할 사이트 주소

site = 'https://tobepotato.tistory.com/'

# 수집하고자 하는 페이지를 나타내는 값

# 처음에는 빈공간으로

page = ''

while True :

time.sleep(1)

# 기존에 출력된 것을 청소한다.

clear_output(wait=True)

print(f'{site}{page} 수집중...')

# 페이지 요청

soup = getSource(site + page)

# 현제 페이지에서 데이터를 가져와 저장한다.

getData(soup, 'tistoryData.csv')

# 다음 페이지 정보를 가져온다.

page = getNextPage(soup)

if page == None :

print('수집완료')

break

그런데..

위 코드를 돌리면? csv 파일이 요지경이다...💢💢💢

< 문제 상황🚨 >

1. 한 행에 제목-카테고리-날짜 로 출력되지 않고 제목과 카테고리-날짜 이렇게 한 글 당 두 행씩 출력되고 있다.

2. 이전, prev 단추도 같이 긁어어고 있다.

3. None 값이 많아서 빈칸이 많다.

< 해결하기 ✅ >

일단 None 값이 아닌 데이터만 가져오기 위해서

if title and category and date :

data_list.append({

'제목': title,

'카테고리': category,

'작성날짜': date

})

리스트에 데이터를 담을 때 조건문으로 넣어서

title, category, date가 None이 아닐 때를 가정하였다.

| < 문제 상황🚨 > 1. 한 행에 제목-카테고리-날짜 로 출력되지 않고 제목과 카테고리-날짜 이렇게 한 글 당 두 행씩 출력되고 있다. 2. 이전, prev 단추도 같이 긁어어고 있다. |

그리고 내부의 태그들을 가져올 때, 양쪽 공백을 제거하는

title = a3.text.strip() if a3 else None

category = a4.text.strip() if a4 else None

date = a5.text.strip() if a5 else None

위 코드들을 모두 삭제했다.

이유는 일단 날 것 그대로의 출력을 보고 무엇을 고쳐야할지 보기 위해서이다.

그럼 아래와 같이 파일이 만들어 졌다 !!

prev, next 단추도 없어지고, 글 하나 당 하나의 행으로 잘 출력된다.

근데 이제 html 코드가 앞 뒤로 딸려 나온다는게 문제..

| < 문제 상황🚨 > 4. html 태그 들이 앞 뒤로 출력되는 현상 (새로운 문제 💢) |

gpt에게 물어본 결과 ...

a4 = div.select_one('a')

a 태그를 가져오는 것에서 부터 문제가 비롯되었다고 한다.

✅ 빠르게 정리하면:

- 현재 크롤링 대상 페이지에는 명확한 카테고리 텍스트가 없고,

- a 태그는 이미지나 포스트 링크 역할만 하고 있어요.

- 그래서 .text를 해도 비어있거나 의미 없는 텍스트가 나오는 겁니다.

라고 한다.. 그래서 'a'에 접근하지 않고 'a.link_cate' 로 접근 했더니

드디어 내가 원하는 결과물이 나왔다 !

link_cate가 무엇이냐면... 바로 빨간색 부분

<a href="/category/%EB%A9%8B%EC%9F%81%EC%9D%B4%EC%82%AC%EC%9E%90%EC%B2%98%EB%9F%BC%20%E0%BB%92%28%E2%8A%99%E1%B4%97%E2%8A%99%29%E0%A5%AD%E2%9C%8E" class="link_cate">멋쟁이사자처럼 ໒(⊙ᴗ⊙)७✎</a>

| < 문제 상황🚨 > |

코드 까지 붙여넣기 하면 글이 너무 길어지니까 Py 파일을 올려둬야겠다 (기록용)

결국 해낸 나 정말 칭찬해 !!

💭 느낀점

첫 번째 프로젝트는 강사님께서 쉬운 사이트로 주셔서 기존 코드만 따라가면 크게 어렵지 않았는데,

두 번째 프로젝트는 개인 혼자서 하는거다 보니까 막히면 너무 어려웠다.

특히 카테고리 태그가 당연히 a인줄 알았는데 class라는 객체를 생각못했다.

암튼 gpt 없이는 깔끔한 크롤링이 어려웠을거다 ㅜ

그래도 어렵게 크롤링 해왔으니까 다음 프로젝트는 좀 더 수월하게 할거 같다 ^^

역시 힘들게 배워야 머리에 오래 남는법 😌

출처 : 멋쟁이사자처럼, 감자슈니